前言

随着个人站点的博客文章和文档内容日益丰富,高效的内容检索功能变得尤为重要。经过深入调研和比较,我最终选择了 Algolia 作为个人站点的搜索引擎解决方案。

这一选择主要基于以下几个关键因素:

- 成本效益高:提供慷慨的免费计划,适合个人站点使用

- 集成便捷:提供多种语言的SDK和API,易于与现有站点架构整合

- 用户体验优异:毫秒级响应速度,智能排序算法,拼写纠错等高级功能

基础配置

由于每个站点的技术栈和架构各不相同,Algolia提供了灵活多样的集成方案。在开始配置前,建议先阅读 Algolia官方文档,了解适合自己站点的部署方式。

一般而言,Algolia的集成流程包括以下几个步骤:

- 创建Algolia账户:注册并创建应用和索引

- 配置索引设置:设置可搜索属性、排序规则和同义词等

- 上传数据:通过API或爬虫将站点内容添加到索引

- 前端集成:在站点中添加搜索界面和功能

在我的实践中,最具挑战性的部分是第三步——如何高效地将站点内容上传到Algolia索引,这也是本文重点分享的内容。

实战踩坑记录

本文核心价值在于分享我在实际部署Algolia过程中遇到的各种技术挑战及其解决方案。作为免费计划用户,我不仅需要应对技术层面的问题,还需要在Algolia的资源限制下寻找最优解决方案。以下是我的实战经验总结,希望能为同样面临这些问题的开发者提供参考。

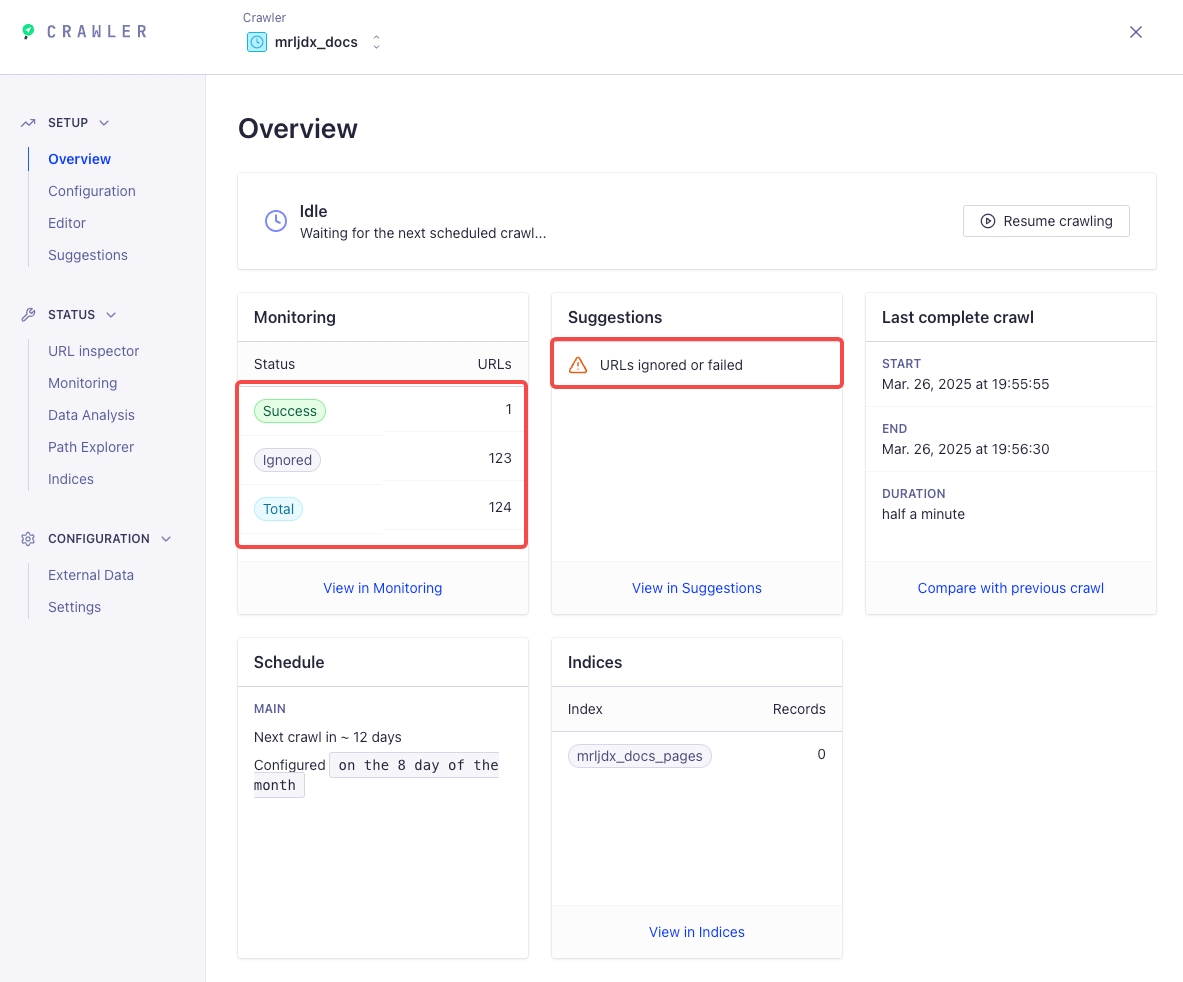

挑战一:Algolia Crawler与Cloudflare的冲突

问题描述:我的个人站点使用Cloudflare进行DNS解析和安全防护。当配置Algolia Crawler通过站点的sitemap抓取页面内容时,频繁遇到404错误。经过排查,发现这是由Cloudflare的反爬虫机制导致的。

尝试的解决方案:

- 调整Cloudflare安全设置:参考社区中遇到类似问题的用户建议,我尝试了多种Cloudflare配置调整,包括Bot Fight Mode、Challenge Passage等设置,但问题依然存在。

- 其他可能的解决方案(未实施):

- 搭建代理服务器模拟正常用户请求,绕过Cloudflare的反爬检测

- 关闭Cloudflare的反爬虫机制

最终决策:放弃使用Crawler方案。虽然Crawler提供了便捷的自动化索引更新机制,但在与Cloudflare共存的环境中难以稳定运行。权衡利弊后,我认为不值得为了搜索功能而降低站点的安全性或增加复杂的代理层。

挑战二:索引数据上传的效率与限制

问题分析:放弃Crawler后,我考虑了手动生成索引文件并上传的方案。然而,这种方法面临两个主要挑战:

- Algolia免费计划的限制:单个JSON文件不能超过100KB

- 维护成本高:每次内容更新都需要手动重新上传索引文件

将整个站点内容导出为多个小于100KB的JSON文件,然后逐一手动上传,这种方式在实际操作中效率极低,尤其是对于内容频繁更新的站点。

解决方案:利用Algolia API实现自动化索引更新

经过研究,我决定通过Algolia提供的API接口来解决这个问题。虽然API使用同样受到免费计划的限制,但可以通过编程方式自动化整个过程,大大提高效率。

实现流程:

我设计了一个完整的自动化索引更新流程,并将其集成到站点的CI/CD管道中:

这种方式的优势在于:

- 一次性开发:只需编写一次代码

- 自动化执行:集成到CI流程,无需人工干预

- 增量更新:可以实现只更新变更内容

进阶优化:增量更新与性能提升

在基本实现自动化索引更新后,我进一步优化了解决方案,重点关注以下几个方面:

增量更新机制

通过代码自动化更新的一个显著优势是可以实现增量更新。具体做法是:

- 内容变更检测:在CI流程中比较最新内容与上一版本的差异

- 选择性更新:只将新增、修改或删除的内容通过API更新到Algolia

- 版本控制:维护索引内容的版本记录,便于回滚和审计

这种增量更新机制不仅提高了索引更新的效率,还避免了因全量更新可能导致的内容同步延迟和搜索结果不一致问题。

性能优化技巧

在实际实现过程中,我还采用了以下技巧来优化性能:

- 批量处理:将索引更新请求打包成批次,减少API调用次数

- 内容压缩:对长文本内容进行智能截断,确保在保留关键信息的同时不超过大小限制

- 异步处理:使用异步任务处理大量索引更新,避免阻塞CI流程

总结与思考

通过这次实践,我不仅解决了个人站点的搜索功能需求,还积累了宝贵的技术经验。回顾整个过程,有几点值得分享的思考:

- 技术选型的权衡:在选择第三方服务时,需要综合考虑功能、成本、集成难度等多方面因素

- 限制下的创新:免费计划的限制反而促使我思考更高效的实现方式

- 自动化的价值:前期投入开发自动化流程,换来的是长期的效率提升

希望这篇文章能为同样面临站点搜索需求的开发者提供有价值的参考。如果你有任何问题或更好的实现思路,欢迎与我交流讨论。